In meiner ersten Podcast-Folge spreche ich mit Jakob Schuster über seinen Ansatz, wie aus Fußballstatistiken automatisch Spielberichte werden.

Es gibt Momente, auf die man lange hinarbeitet – und dann sind sie plötzlich da: Mein erster eigener Podcast ist online! Ich freue mich riesig, dass es endlich losgeht. In der ersten Folge geht es direkt um ein Thema, das mich schon lange fasziniert: Wie können KI-Modelle aus rohen Daten lebendige, authentische Texte machen?

Anwendungsfälle gibt es viele. Stellt euch vor, ihr müsst hunderte Wohnungsbeschreibungen für eine Immobilienplattform verfassen. Die Grundstruktur der Texte ist oft ähnlich, aber die Details hängen von den Basisdaten ab:

- Wie viele Fenster haben die Räume, in welche Richtung zeigen sie? → Ist die Wohnung hell und freundlich?

- Wie viele Räume auf wie vielen Quadratmetern? → Wirkt die Wohnung großzügig?

Das Ziel: Aus Rahmendaten ansprechende, authentisch klingende Beschreibungen zu erstellen – ohne dass es steril oder monoton wirkt.

In unserem Fall geht es aber nicht um Wohnungen, sondern um Fußballspiele. Nach dem Schlusspfiff entstehen unzählige Berichte, Posts und Analysen für verschiedene Zielgruppen. Doch allen liegt dasselbe zugrunde: die Spielstatistiken und Events. Wer stand in der Startaufstellung? Wer wurde eingewechselt? Wer spielte wann einen Pass, wer schoss aufs Tor? Gab es gelbe oder rote Karten? Neben diesen Events fließen auch übergreifende Statistiken wie Druckphasen oder Vereinsinformationen ein – sie bilden die Basis jeder Spielberichterstattung.

Wie schaffen wir es nun, aus diesen Daten echte, authentische Spielberichte zu formulieren?

Alle Details dazu hört ihr natürlich in unserer Podcast-Folge auf Spotify oder YouTube. Hier ein kurzer Überblick:

➡️ Relevanzfilterung ist entscheidend

Der schwierigste Teil ist nicht die Formulierung, sondern die Auswahl der relevanten Daten aus oft tausenden Events.

➡️ Regeln oft besser als Machine Learning

Bei der Auswahl wichtiger Ereignisse (z. B. Tore, rote Karten, Top-Chancen) haben einfache, regelbasierte Ansätze oft besser funktioniert als ML-Modelle – vor allem bei kleinen Datensätzen.

➡️ Reihenfolge ist weniger kritisch

Sprachmodelle kommen erstaunlich gut mit unsortierten Daten zurecht. Eine perfekte chronologische Sortierung bringt oft wenig zusätzlichen Nutzen.

➡️ Sprachmodelle haben Grenzen

LLMs erzeugen zwar robuste Texte, neigen aber zu „Halluzinationen“ – etwa, wenn sie bewertende Aussagen („schöne Torchance“) hinzufügen, die nicht in den Rohdaten stehen. Außerdem gibt es technische Grenzen bei der Menge an verarbeitbaren Daten.

➡️ Übertragbarkeit auf andere Domänen

Der Ansatz lässt sich auch auf andere Bereiche wie unbekanntere Sportarten oder Immobilienbeschreibungen anwenden – vorausgesetzt, es gibt ausreichend Beispieldaten.

➡️ Human-in-the-loop bleibt wertvoll

Selbst in einem automatisierten System kann ein Mensch, der Events auswählt oder Vorschläge prüft, die Qualität deutlich verbessern.

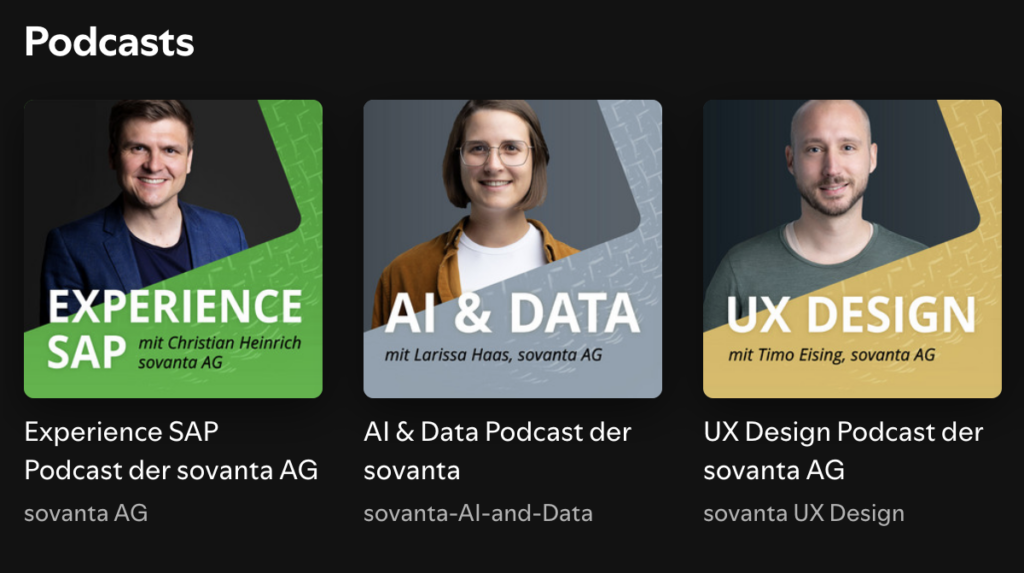

Wenn euch die Folge gefallen hat: Der Plan ist ab sofort jeden Monat eine neue Folge zu veröffentlichen! Bis dahin könnt ihr auch in die anderen Podcasts von meinen Kolleg:innen reinhören, die kann ich nur empfehlen 🙂

Ich freue mich riesig, wenn ihr reinhört, mitdiskutiert und mir Feedback gebt – auf Spotify, YouTube oder direkt hier in den Kommentaren. Das ist erst der Anfang, und ich bin gespannt, wohin die Podcast-Reise uns führt!

Welche Themen wünscht ihr euch für die kommenden Folgen?